Cuando modelos de IA generativa como ChatGPT y Gemini dependen de modelos base entrenados en puntos de datos masivos para dar respuestas, los ingenieros también esperan construir modelos base para entrenar a robots en nuevas habilidades. Sin embargo, recopilar y transferir datos de enseñanza entre sistemas robóticos es extremadamente difícil. Usar tecnologías como realidad virtual (VR) para operar remotamente sistemas de hardware de entrenamiento es costoso en tiempo y esfuerzo, y los videos de internet carecen de demostraciones paso a paso específicas para tareas de robots particulares, con guía limitada.

Recientemente, el Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) y el Instituto de Robótica y Sistemas Autónomos del MIT han desarrollado un método impulsado por simulación llamado "PhysicsGen", que trae esperanza para resolver este dilema. Este método puede personalizar datos de entrenamiento para robots, ayudando a los robots a encontrar las acciones más eficientes para completar tareas.

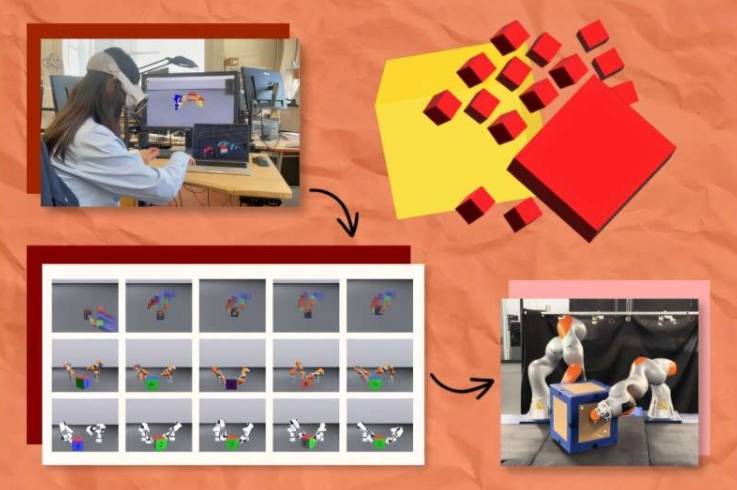

PhysicsGen crea datos que se pueden generalizar a robots y condiciones específicas a través de un proceso de tres pasos. En el primer paso, un headset de VR rastrea la forma en que las manos humanas manipulan objetos (como bloques) y mapea estas interacciones a un simulador físico 3D, visualizando puntos clave de la mano como esferas para reflejar gestos. En el segundo paso, estos puntos se remapean al modelo 3D de un robot específico (como un brazo mecánico) y se mueven a las "articulaciones" exactas del sistema rotatorio. En el tercer paso, PhysicsGen usa optimización de trayectorias para simular el movimiento más efectivo para completar la tarea, permitiendo que el robot sepa el mejor método para ejecutar operaciones (como reposicionar una caja).

Cada simulación es un punto de datos de entrenamiento detallado que guía a los robots a explorar múltiples formas de manipular objetos. Al incorporar políticas, los robots pueden completar tareas de múltiples maneras, probando otras acciones si un método falla. Lujie Yang, estudiante de doctorado en Ingeniería Eléctrica y Ciencias de la Computación del MIT y afiliado a CSAIL, indica: "Estamos creando datos específicos para robots sin necesidad de que los humanos graben demostraciones especializadas para cada máquina, sino expandiendo los datos de manera autónoma y eficiente para que las instrucciones de tareas sean aplicables a una gama más amplia de máquinas".

El potencial de PhysicsGen es enorme. Puede ayudar a los ingenieros a construir conjuntos de datos masivos para guiar el trabajo de brazos mecánicos y manos dexterosas. Por ejemplo, puede ayudar a dos brazos mecánicos a colaborar en la recolección de artículos de almacén y colocarlos en la caja correcta para envío, o guiar a dos robots en el hogar para limpiar vasos de manera colaborativa. Además, puede convertir datos de robots antiguos o diseños de entornos diferentes en instrucciones aplicables a nuevas máquinas, haciendo que los conjuntos de datos anteriores sean más universalmente aplicables.

En las pruebas, PhysicsGen se desempeñó excelentemente. En un experimento virtual, una mano mecánica flotante necesitaba rotar un bloque a una posición objetivo. Entrenado con un conjunto de datos masivo de PhysicsGen, el robot digital ejecutó la tarea con un 81% de precisión, un 60% más que la línea base que aprende solo de demostraciones humanas. Los investigadores también encontraron que PhysicsGen mejora la forma en que brazos mecánicos virtuales colaboran en la manipulación de objetos, con los datos de entrenamiento adicionales creados por el sistema ayudando a dos pares de robots a completar tareas con un 30% más de éxito que los modelos de línea base entrenados puramente por humanos. En un experimento con un par de brazos mecánicos reales, cuando los robots se desviaban de la trayectoria predeterminada o manejaban mal objetos, también podían recuperar la tarea refiriéndose a trayectorias alternativas en la base de datos de enseñanza.

El autor senior Russ Tedrake afirma que esta tecnología de generación de datos guiada por imitación combina las ventajas de las demostraciones humanas con el poder de los algoritmos de planificación de movimiento robótico. En el futuro, los modelos base podrían proporcionar información relevante, mientras que esta tecnología de generación de datos proporcionará soluciones posteriores al entrenamiento para los modelos.

Pronto, PhysicsGen podría expandirse a nuevos dominios, diversificando las tareas que las máquinas pueden ejecutar. Yang da un ejemplo: para enseñar a un robot entrenado solo en limpiar platos a verter agua, el proceso de PhysicsGen no solo genera acciones dinámicas ejecutables para tareas familiares, sino que también crea una biblioteca diversificada de interacciones físicas para ayudar a los robots a completar tareas completamente nuevas.

Sin embargo, los investigadores del MIT advierten que, aunque crear grandes cantidades de datos de entrenamiento ampliamente aplicables ayuda a construir modelos base para robots, esto sigue siendo un objetivo a largo plazo. Actualmente, el equipo liderado por CSAIL está investigando cómo usar recursos no estructurados masivos como PhysicsGen (como videos de internet) como semillas de simulación, convirtiendo contenido visual cotidiano en datos ricos para enseñar a las máquinas a ejecutar tareas no demostradas explícitamente.

Yang y sus colegas también planean hacer que PhysicsGen se aplique mejor a robots de formas y configuraciones variadas, utilizando conjuntos de datos de demostraciones de robots reales para capturar los modos de movimiento de las articulaciones robóticas. Al mismo tiempo, planean incorporar aprendizaje por refuerzo para que los conjuntos de datos de PhysicsGen superen los ejemplos proporcionados por humanos, y utilizar tecnologías de percepción avanzadas para mejorar el proceso, ayudando a los robots a percibir e interpretar el entorno circundante, analizar y adaptarse a la complejidad del mundo físico. Actualmente, PhysicsGen demuestra el rol de la IA en el entrenamiento de diferentes robots para manipular objetos rígidos, y en el futuro podría ayudar a los robots a encontrar los mejores métodos para manejar objetos blandos (como frutas) y objetos deformables (como arcilla), aunque estas interacciones son actualmente difíciles de simular.