En el campo de la fabricación de equipos de alta gama, la innovación en tecnología robótica siempre ha sido una fuerza clave para impulsar el desarrollo de la industria. Los robots industriales tradicionales y para entornos peligrosos son fáciles de modelar y controlar, pero son rígidos y difíciles de operar en espacios estrechos y terrenos irregulares; mientras que los robots biomiméticos suaves son fuertes en adaptabilidad ambiental y pueden penetrar lugares difíciles de alcanzar, pero la realización de funciones flexibles a menudo depende de una serie de sensores a bordo y modelos espaciales personalizados para cada robot, con altos costos y complejidad.

Recientemente, un grupo de investigación del MIT ha logrado un gran avance, desarrollando un sistema de control de aprendizaje profundo con bajos requisitos de recursos, trayendo un nuevo cambio para el control de robots biomiméticos. Los resultados de la investigación se han publicado en la revista Nature.

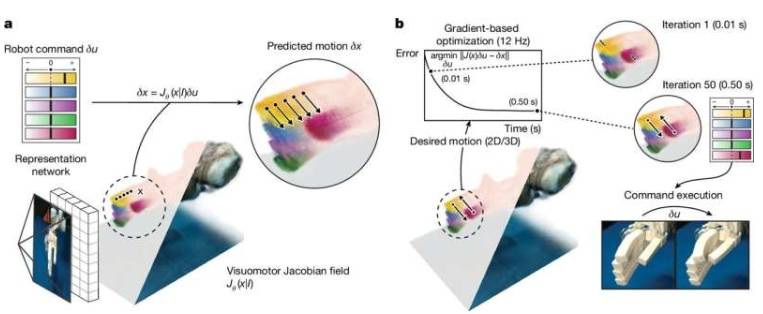

El grupo de investigación abandonó los métodos complejos tradicionales y adoptó un nuevo enfoque, entrenando una red neuronal profunda en videos multiperspectiva de varios robots ejecutando comandos aleatorios durante dos a tres horas, para que aprenda a reconstruir la forma y el rango de movimiento del robot solo a partir de una sola imagen. Previamente, el diseño de control de aprendizaje automático requería personalización experta y sistemas de captura de movimiento costosos, careciendo de sistemas de control universales, limitando la aplicación y reduciendo drásticamente la practicidad del diseño rápido de prototipos. El nuevo método del MIT libera el diseño de hardware robótico de la capacidad de modelado manual, ya que el modelado manual anterior requería fabricación de precisión, materiales caros, amplias capacidades de sensado y dependencia de componentes rígidos tradicionales.

En las pruebas, el nuevo método de aprendizaje automático de una sola cámara se desempeñó excelentemente. En pruebas con varios sistemas robóticos como manos neumáticas impresas en 3D, muñecas de expansión suave, mano Allegro de 16 grados de libertad y brazo mecánico de bajo costo Poppy, se logró un control de alta precisión. El error de movimiento articular fue inferior a 3 grados, el error de control de la punta del dedo inferior a 4 mm (aproximadamente 0.15 pulgadas), y también compensó los cambios en el movimiento del robot y el entorno circundante.

Sizhe Lester Li, estudiante de doctorado del MIT, señala en un artículo temático de la red que esta investigación marca el cambio de los robots de la programación a la enseñanza. Actualmente, muchas tareas robóticas requieren una gran cantidad de ingeniería y codificación; en el futuro, se podrá mostrar la tarea a los robots para que la aprendan de manera autónoma y logren objetivos.

Sin embargo, este sistema depende actualmente solo de la visión y no es aplicable en tareas flexibles que requieren percepción de contacto y manipulación háptica, y su rendimiento disminuye cuando las indicaciones visuales son insuficientes. Los investigadores indican que agregar tacto y otros sensores puede permitir que los robots ejecuten tareas más complejas, y también lograr un control de automatización robótica más amplio, incluyendo aquellos robots con sensores embebidos mínimos o nulos. Esta innovación abre una nueva ruta para el desarrollo de tecnología robótica en el campo de la fabricación de equipos de alta gama, con la esperanza de impulsar la industria hacia una nueva etapa de desarrollo.