Los robots tradicionales, como los utilizados en entornos industriales y peligrosos, son fáciles de modelar y controlar, pero demasiado rígidos para operar en espacios estrechos y terrenos irregulares. Los robots blandos biomiméticos son mejores para adaptarse al entorno y manipular en lugares difíciles de alcanzar.

Sin embargo, estas funciones más flexibles suelen requerir una serie de sensores integrados y modelos espaciales personalizados para cada robot individual.

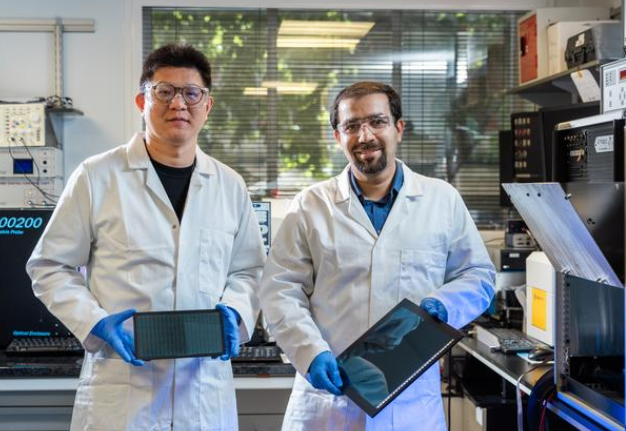

Un grupo de investigación del Instituto Tecnológico de Massachusetts (MIT) adoptó un nuevo enfoque de bajo requerimiento de recursos, desarrollando un sistema de control de aprendizaje profundo mucho menos complejo que puede enseñar a robots blandos e inspirados en la biología a moverse y seguir comandos solo a través de una imagen.

Sus resultados de investigación se publicaron en la revista Nature.

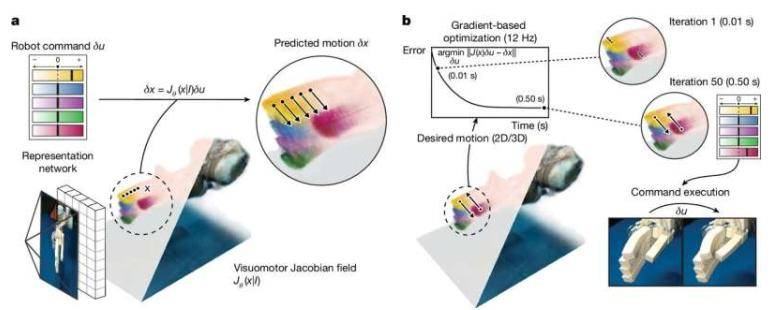

Al entrenar una red neuronal profunda con videos multiperspectiva de varios robots ejecutando comandos aleatorios durante dos a tres horas, los investigadores entrenaron la red para reconstruir la forma y el rango de movimiento del robot solo a partir de una imagen.

Los diseños de control de aprendizaje automático anteriores requerían personalización experta y sistemas costosos de captura de movimiento. Debido a la falta de sistemas de control universales, sus aplicaciones estaban limitadas y reducían enormemente la practicidad del diseño rápido de prototipos.

Los investigadores señalaron en el artículo: “Nuestro método libera el diseño de hardware de robots de la capacidad de modelado manual, que en el pasado requería fabricación precisa, materiales costosos, capacidades de sensado extensas y dependencia de componentes rígidos tradicionales”.

El nuevo método de aprendizaje automático de una sola cámara logra un control de alta precisión en pruebas con varios sistemas de robots, incluyendo actuadores neumáticos impresos en 3D, muñecas de expansión blanda, la mano Allegro de 16 grados de libertad y el brazo mecánico Poppy de bajo costo.

Estas pruebas lograron exitosamente errores de movimiento articular menores a 3 grados y errores de control de punta de dedo menores a 4 milímetros (aproximadamente 0.15 pulgadas). El sistema también puede compensar cambios en el movimiento del robot y el entorno circundante.

El estudiante de doctorado del MIT, Sizhe Lester Li, señaló en un artículo temático en línea: “Esta investigación marca un cambio de la programación a la enseñanza en la robótica”.

Hoy en día, muchas tareas de robots requieren una gran cantidad de ingeniería y codificación. En el futuro, imaginamos mostrar a los robots lo que deben hacer y dejar que aprendan autónomamente cómo lograrlo.

Dado que este sistema depende solo de la visión, puede no ser adecuado para tareas más flexibles que requieran percepción de contacto y manipulación háptica. Su rendimiento también podría disminuir en casos de indicaciones visuales insuficientes.

Los investigadores indicaron que agregar sensores táctiles y otros podría permitir que los robots realicen tareas más complejas. Además, podría lograr un control de automatización robótica más amplio, incluyendo robots con muy pocos o ningún sensor integrado.