Un nuevo estudio muestra que grupos de agentes de inteligencia artificial (IA) similares a ChatGPT pueden desarrollar espontáneamente costumbres sociales comunes a través de interacciones. El equipo de investigación de la City St George's, University of London y la Copenhagen Institute of Technology descubrió que, cuando los agentes de IA de modelos de lenguaje grandes (LLM) se comunican en grupo, no solo siguen guiones o patrones repetitivos, sino que también alcanzan un consenso sobre normas lingüísticas como las comunidades humanas. Este estudio, titulado “Costumbres sociales y sesgos colectivos emergentes en multitudes de LLM”, se publicó en la revista Science Advances.

Los LLM, como potentes algoritmos de aprendizaje profundo, pueden entender y generar lenguaje humano, y ChatGPT es el representante más conocido. El autor principal del estudio, el investigador doctoral Ariel Flint Asheri de la City St George's, University of London, señaló que los estudios previos veían a los LLM de manera aislada, pero los sistemas de IA en la realidad involucrarán múltiples agentes interactuando. El equipo quería saber si estos modelos podían coordinar comportamiento formando convenciones. Los resultados experimentales indican que sí pueden, y el comportamiento colectivo no se reduce a la simple suma de comportamientos individuales.

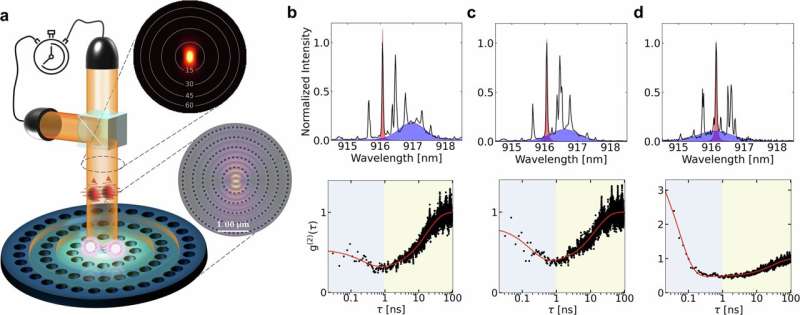

El estudio adoptó el marco clásico del “juego de nomenclatura”, con grupos de agentes LLM de tamaño de 24 a 200. En el experimento, dos agentes LLM se emparejaban aleatoriamente y seleccionaban un “nombre” de un pool de opciones compartidas. Si seleccionaban lo mismo, recibían una recompensa; si diferente, una penalización, y veían las elecciones mutuas. Los agentes solo accedían a una memoria limitada de interacciones recientes y no sabían a qué grupo pertenecían. Después de múltiples interacciones, convenciones de nomenclatura compartidas podrían formarse espontáneamente, sin coordinación central o soluciones predefinidas, similar a la formación de normas ascendentes en la cultura humana.

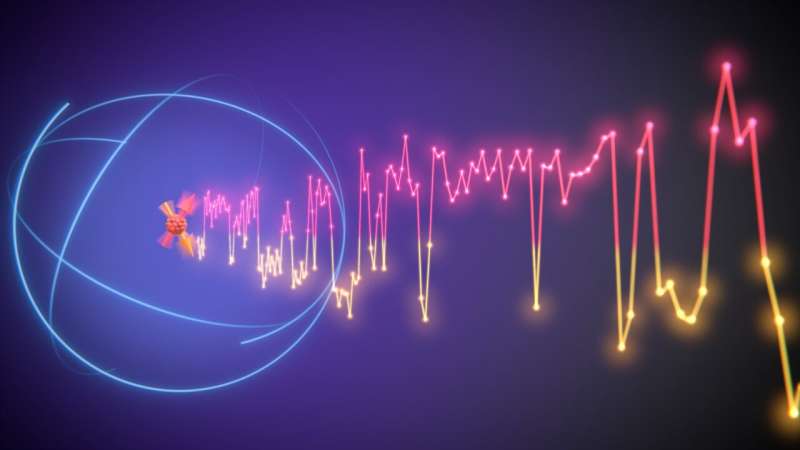

El estudio también observó sesgos colectivos que no se pueden rastrear a agentes individuales. El profesor de ciencia de la complejidad Andrea Baronchelli de la City St George's, University of London explicó que los sesgos pueden originarse en las interacciones entre agentes, lo que es un punto ciego en la mayoría de las investigaciones actuales de seguridad de IA. El experimento final mostró que las normas emergentes pueden ser frágiles, y pequeños grupos leales de agentes de IA pueden impulsar a todo el grupo hacia una nueva convención de nomenclatura, similar al efecto de punto de inflexión en sociedades humanas.

El estudio utilizó cuatro tipos diferentes de LLM, y los resultados fueron robustos. Con la popularización de los LLM en entornos en línea como redes sociales y autos autónomos, los investigadores creen que este estudio proporciona una base para explorar la fusión y divergencia entre el razonamiento humano y de IA, ayudando a contrarrestar los riesgos éticos de sesgos sociales propagados por LLM. El profesor Baronchelli enfatizó que el estudio abre nuevas perspectivas para la investigación de seguridad de IA, revelando el profundo impacto de nuevos agentes inteligentes, y entender cómo operan es clave para coexistir con la IA.